深度学习作为人工智能的核心技术,正在以前所未有的速度重塑各行各业。从医疗影像诊断到自动驾驶,从智能语音助手到金融风险预测,深度学习驱动的AI应用已经成为创新和增长的关键引擎。如何有效利用深度学习技术开发出真正有价值、可落地的人工智能应用呢?本文将结合世界顶级科学家在AI领域的前沿洞见,为您系统梳理开发路径与核心技术要点。

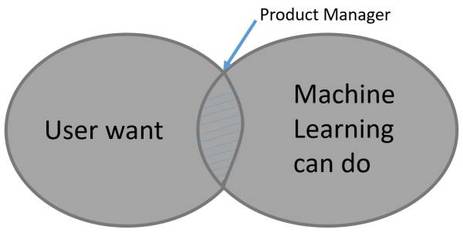

明确问题定义与数据基础是成功的起点。任何人工智能应用的开发都必须始于对实际业务需求的深刻理解。开发者需要与领域专家紧密合作,将复杂的现实问题转化为具体的、可量化的机器学习任务。例如,在医疗领域,这可能意味着将“辅助医生诊断肺癌”的目标转化为“基于CT影像的肺结节分类与分割”任务。与此数据是深度学习的“燃料”。确保数据的规模、质量和标注的准确性至关重要。顶级科学家们常常强调,一个高质量的专用数据集,其价值有时甚至超过一个复杂的模型架构。因此,在项目初期,投入资源进行数据采集、清洗和标注,是后续所有工作的基石。

模型的选择、设计与训练构成了技术核心。在深度学习领域,模型架构日新月异。开发者不必总是从零开始,而是可以站在巨人的肩膀上。对于图像识别,卷积神经网络(CNN)及其变体(如ResNet、EfficientNet)是成熟的选择;对于自然语言处理,Transformer架构(如BERT、GPT系列)已成为主流。关键在于根据任务特性进行适配与优化。训练过程则是一门平衡的艺术,涉及损失函数的设计、优化器的选择(如Adam、SGD)、学习率的调整以及防止过拟合的策略(如数据增强、Dropout、正则化)。世界顶级实验室的实践表明,采用系统化的实验跟踪与管理工具(如MLflow、Weights & Biases),能够高效地迭代模型,加速开发进程。

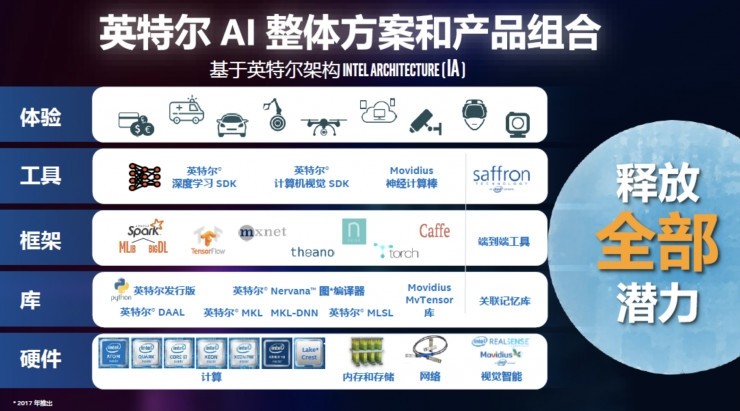

从模型到产品:工程化与部署是关键一跃。一个在实验环境中表现优异的模型,距离成为一个稳定、可靠的产品还有很长的路。模型压缩(如剪枝、量化)和加速推理技术(如使用TensorRT、OpenVINO)对于在资源受限的边缘设备(如手机、物联网设备)上部署至关重要。构建完整的AI应用管道(Pipeline)——包括数据输入、预处理、模型推理、后处理以及结果输出——并确保其可扩展性、稳定性和低延迟,是工程团队的核心挑战。微服务架构和容器化技术(如Docker、Kubernetes)已成为现代AI系统部署的标准实践。

伦理考量与持续迭代是不可或缺的维度。顶级科学家们在演讲中不断呼吁,AI应用的开发必须嵌入伦理设计。这包括评估并减轻模型的偏见(Bias),确保其决策的公平性;重视数据的隐私保护(如采用联邦学习);以及保证系统的透明度和可解释性,尤其是在医疗、司法等高风险领域。开发并非在部署后结束,而是一个持续监控、评估和更新的循环。通过收集生产环境中的新数据(并妥善处理数据漂移问题),不断重新训练和优化模型,才能使AI应用长久保持其有效性和竞争力。

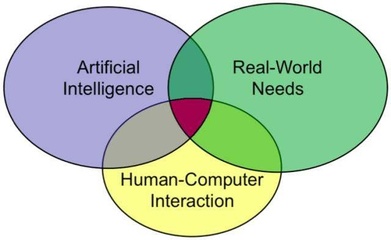

使用深度学习开发人工智能应用是一个融合了领域知识、数据科学、算法创新与软件工程的系统性工程。它要求开发者不仅紧跟技术前沿(如自监督学习、大语言模型的新进展),更要深刻理解应用场景,并以负责任的态度将技术转化为造福社会的产品。正如一位顶尖AI科学家所言:‘最好的技术是那些看不见的技术,它们无缝融入生活,切实解决了问题。’ 这应当是所有AI应用开发者的终极目标。